Warum KI manchmal „vergisst“ oder halluziniert

Hast du schon einmal mit einem KI-Chatbot gesprochen und festgestellt, dass er auf veraltete Informationen zurückgreift oder sich Details einfach ausdenkt? Dieses Phänomen nennt man in der KI-Welt „Halluzination“ – die KI erfindet Fakten, die plausibel klingen, aber schlichtweg falsch sind. Das Problem resultiert daraus, dass die KI die Antwortsätze aus Tokenwahrscheinlichkeiten erzeugt.

Moderne KI-Systeme wie ChatGPT oder ähnliche Sprachmodelle wurden mit enormen Mengen an Textdaten trainiert. Doch dieses Wissen ist gewissermaßen „eingefroren“ – es stammt aus dem Zeitpunkt des Trainings und kann nicht einfach aktualisiert werden. Wenn du also nach aktuellen Börsenkursen, den neuesten Unternehmensinformationen oder spezifischen internen Dokumenten fragst, steht die KI vor einem Problem und antwortet gegebenenfalls mit erfundenen Informationen.

Hier kommen zwei spannende Konzepte ins Spiel, die das Problem elegant lösen können: Embeddings und Retrieval-Augmented Generation (RAG). Diese beiden Technologien arbeiten Hand in Hand und ermöglichen es KI-Systemen, auf aktuelle, spezifische und relevante Informationen zuzugreifen – ohne dass das gesamte Modell neu trainiert werden muss.

Was sind Embeddings?

Stell dir vor, du müsstest einem Computer erklären, dass „Berlin“ und „Paris“ mehr gemeinsam haben als „Berlin“ und „Apfel“. Wie würdest du das anstellen?

Genau hier setzen Embeddings an. In der KI-Welt beschreibt es einen Prozess, bei dem Texte, Wörter oder ganze Dokumente in mathematische Zahlenreihen umgewandelt werden – sogenannte Vektoren. Aber es geht nicht einfach nur um irgendwelche Zahlen. Diese Vektoren sind so konstruiert, dass sie die Bedeutung und den Kontext des Textes erfassen. Wörter oder Sätze mit ähnlicher Bedeutung erhalten ähnliche Zahlenwerte. Das ist vergleichbar mit einem mehrdimensionalen Raum, in dem verwandte Konzepte nah beieinanderliegen.

Ein praktisches Beispiel: Batterielebensdauer und Akkulaufzeit

Lass uns das an einem konkreten Beispiel verdeutlichen. Angenommen, du suchst in einer Produktdatenbank nach Informationen zur „Batterielebensdauer“ eines Smartphones. Ein traditionelles Suchsystem würde nur Dokumente finden, die exakt das Wort „Batterielebensdauer“ enthalten.

Aber was ist mit Dokumenten, die stattdessen von „Akkulaufzeit“ sprechen? Für Menschen ist sofort klar: Beide Begriffe gehören im Wesentlichen zum gleichen Thema, sind aber keine Synonyme. Ein traditionelles IT-System würde diese thematische Verbindung nicht erkennen.

Hier zeigt sich die Stärke von Embeddings: Wenn beide Begriffe in Vektoren umgewandelt werden, liegen sie im mathematischen Raum sehr nah beieinander, weil sie semantisch ähnlich sind. Das Embedding-Modell hat während seines Trainings gelernt, dass beide Begriffe im gleichen Kontext verwendet werden – etwa bei Smartphones, Laptops und Tablets. Sie beschreiben ähnliche Eigenschaften (z.B. Dauer, Zeit, Energie) und tauchen oft in denselben Dokumenten auf. Zudem werden sie häufig mit ähnlichen Wörtern kombiniert.

Wenn du also fragst: “Wie lange hält der Akku meines neuen Smartphones XY?”, dann findet ein Embedding-basiertes System automatisch relevante Dokumente über “Smartphone-Akkus” und alle relevanten Texte zu Begriffen wie “Batterielebensdauer”, „Akkukapazität“, „Energieverbrauch“ oder „Batterieeffizienz“.

Diese semantische Ähnlichkeit ermöglicht eine völlig neue Art der Suche. Statt nach exakten Wortübereinstimmungen zu suchen, versteht das System die Bedeutung hinter deiner Anfrage. Du findest relevante Informationen auch dann, wenn sie andere Formulierungen verwenden, da Synonyme, verwandte Begriffe und kontextuelle Zusammenhänge erkannt werden. Die Suche funktioniert sogar über Sprachen hinweg, wenn mehrsprachige Embeddings verwendet werden.

Was ist Retrieval-Augmented Generation (RAG)?

RAG steht für Retrieval-Augmented Generation – auf Deutsch etwa „abrufgestützte Erzeugung“. Der Name klingt sperrig, aber das Konzept ist elegant und einleuchtend.

Die Grundidee: Eine KI mit Nachschlagewerk

Stell dir einen brillanten, aber vergesslichen Wissenschaftler vor. Er hat ein enormes Allgemeinwissen, aber für spezifische Details muss er in einer gut organisierten Bibliothek nachschlagen. Genau so funktioniert RAG.

Anstatt sich nur auf das „eingefrorene“ Wissen des KI-Modells zu verlassen, gibt Retrieval-Augmented Generation der KI Zugriff auf eine externe Wissensdatenbank. Wenn du eine Frage stellst, durchsucht das System zunächst diese Datenbank nach relevanten Informationen und nutzt diese dann, um eine fundierte, aktuelle und korrekte Antwort zu generieren.

Retrieval-Augmented Generation in drei Schritten

Der RAG-Prozess lässt sich in drei einfache Schritte unterteilen:

Schritt 1 – Retrieval (Abrufen): Wenn du eine Frage stellst, durchsucht das System eine Datenbank nach den relevantesten Informationen. Das können Unternehmensdokumente, Produkthandbücher, aktuelle Nachrichtenartikel oder jede andere Textquelle sein.

Schritt 2 – Augmentation (Erweitern): Die gefundenen Informationen werden deiner ursprünglichen Anfrage hinzugefügt. Die KI erhält also nicht nur deine Frage, sondern auch den relevanten Kontext aus der Datenbank.

Schritt 3 – Generation (Erzeugen): Mit dieser erweiterten Information generiert die KI eine Antwort, die auf echten, aktuellen Daten basiert statt auf möglicherweise veraltetem Trainingswissen.

Der entscheidende Unterschied

Der große Unterschied zu klassischen KI-Modellen liegt in der Aktualität und Spezifität. Ein Standard-Sprachmodell antwortet nur basierend auf seinem Training. RAG hingegen holt sich die Informationen in Echtzeit aus einer Wissensdatenbank. Das bedeutet:

- Aktuelle Informationen: Die Datenbank kann täglich aktualisiert werden

- Spezifisches Wissen: Du kannst firmeneigene oder spezialisierte Dokumente einbinden

- Nachvollziehbarkeit: Die Quellen der Antworten können angegeben werden

- Reduzierte Halluzinationen: Die KI „erfindet“ weniger, da sie auf echte Dokumente zurückgreift

Wie RAG und Embeddings zusammenarbeiten

Retrieval-Augmented Generation und Embeddings sind keine konkurrierenden Technologien, sondern perfekte Partner. Embeddings sind die Grundlage, auf der RAG aufbaut.

Der technische Ablauf – einfach erklärt

Wenn du ein RAG-gestütztes KI System in einem Unternehmen implementieren möchtest, läuft das typischerweise so ab:

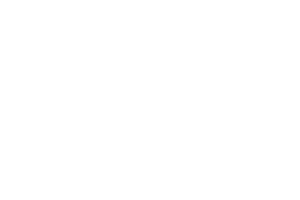

Phase 1 – Vorbereitung der Wissensdatenbank:

Alle relevanten Dokumente – seien es PDFs, Word-Dateien, Webseiten oder Datenbanken – werden gesammelt. Diese werden in kleinere Abschnitte aufgeteilt, oft „Chunks“ genannt. Jeder dieser Abschnitte wird dann durch ein Embedding-Modell in einen Vektor umgewandelt. Diese Vektoren werden in einer speziellen Vektordatenbank gespeichert.

Phase 2 – Die Suchanfrage:

Wenn du als Nutzer eine Frage stellst, wird auch diese Frage zunächst in einen Vektor umgewandelt – mit demselben Embedding-Modell. Nun kommt die Magie: Das System vergleicht den Vektor deiner Frage mit allen Vektoren in der Datenbank und findet die ähnlichsten – also die inhaltlich relevantesten – Dokumente.

Phase 3 – Die Antwortgenerierung:

Die gefundenen relevanten Textabschnitte werden zusammen mit deiner ursprünglichen Frage an das Sprachmodell übergeben. Das Modell kann nun eine präzise Antwort formulieren, die auf echten, relevanten Informationen basiert.

Ein konkretes Beispiel

Lass uns das anhand eines praktischen Beispiels durchspielen:

Deine Frage: „Wie lange hält der Akku des neuen Smartphones XY?“

Was im Hintergrund passiert:

- Deine Frage wird in einen Embedding-Vektor umgewandelt

- Das System durchsucht die Vektordatenbank und findet nicht nur Dokumente mit den Worten Akku und Smartphone, sondern auch:

- Das technische Datenblatt, das von „Batterielebensdauer“ spricht

- Einen Testbericht, der „Akkukapazität“ erwähnt

- Eine Produktbeschreibung über „Energieeffizienz“

- Kundenbewertungen zur „Batterieperformance“

- All diese semantisch ähnlichen Informationen werden dem KI-Modell zusammen mit deiner Frage als Kontext übergeben

- Die KI kann nun eine umfassende Antwort generieren, die Informationen aus allen relevanten Quellen kombiniert – unabhängig davon, welche Begriffe dort verwendet wurden

Warum funktioniert das so gut?

Die Kombination aus Embeddings und RAG löst mehrere Probleme gleichzeitig:

- Semantisches Verständnis: Durch Embeddings findet das System auch relevante Dokumente, die nicht die exakten Suchwörter enthalten

- Effizienz: Es müssen nicht alle Dokumente durchgelesen werden, sondern nur die mathematisch ähnlichsten

Herausforderungen und Grenzen

Trotz aller Vorteile gibt es auch Herausforderungen, die du kennen solltest:

Datenqualität ist entscheidend

Wenn deine Wissensdatenbank veraltet, unvollständig oder fehlerhaft ist, werden auch die Antworten entsprechend sein. „Garbage in, garbage out“ gilt hier besonders.

Lost in the Middle – das Kontextfensterproblem

Ein weiteres oft unterschätztes Problem betrifft die Verarbeitung langer Kontexte. Auch wenn moderne Sprachmodelle mittlerweile riesige Kontextfenster von 100.000 oder mehr Tokens unterstützen, bedeutet das nicht automatisch, dass alle Informationen gleich gut genutzt werden. Studien haben gezeigt, dass Informationen, die in der Mitte eines sehr langen Kontexts platziert werden, deutlich schlechter abgerufen und verarbeitet werden als solche am Anfang oder Ende – ein Phänomen, das als „Lost in the Middle“ bekannt ist. Zudem verschlechtert sich die Qualität der Antworten tendenziell, je mehr Kontext hinzugefügt wird, selbst wenn dieser theoretisch relevant ist. Jedes zusätzliche Dokument im Kontext erhöht nicht nur die API-Kosten erheblich, sondern kann paradoxerweise auch die Antwortqualität verschlechtern, indem es das Modell „verwirrt“ oder von den wirklich wichtigen Informationen ablenkt. Deshalb ist es entscheidend, nicht einfach möglichst viele gefundene Dokumente in den Kontext zu packen, sondern selektiv nur die relevantesten auszuwählen und diese strategisch zu positionieren – idealerweise am Anfang oder Ende des Kontexts.

Initiale Einrichtung erfordert Aufwand

Die erste Implementierung eines RAG-Systems stellt eine komplexe Aufgabe dar, die mehrere aufeinander aufbauende Schritte erfordert. Zunächst müssen relevante Dokumente identifiziert und systematisch gesammelt werden. Diese Dokumente gilt es anschließend möglicherweise zu bereinigen und in eine geeignete Struktur zu bringen.

Ein weiterer wesentlicher Schritt besteht in der Auswahl eines passenden Embedding-Modells, das die Grundlage für die semantische Suche bildet. Darauf aufbauend muss die technische Infrastruktur aufgesetzt werden, wozu insbesondere die Einrichtung einer Vektordatenbank sowie die Anbindung erforderlicher APIs gehören. Abschließend ist es notwendig, das gesamte System ausgiebig zu testen und schrittweise zu optimieren, um eine zuverlässige und performante Lösung zu gewährleisten.

Wartung und Pflege notwendig

Dokumente müssen regelmäßig aktualisiert werden. Veraltete Informationen müssen aus dem Kontext entfernt oder ersetzt werden. Das erfordert klare Prozesse und Verantwortlichkeiten in deinem Unternehmen.

Technische Komplexität

Auch wenn RAG konzeptionell einfach klingt, steckt dahinter eine beträchtliche technische Infrastruktur. Zu den grundlegenden Komponenten zählt zunächst eine Vektordatenbank, die als Speicher- und Abfragesystem dient. Hinzu kommt ein Embedding-Modell, wobei sowohl kommerzielle Lösungen wie OpenAI Embeddings als auch Open-Source-Alternativen zur Verfügung stehen. Ein weiterer zentraler Baustein ist ein leistungsfähiges Sprachmodell, das für die eigentliche Generierung der Antworten verantwortlich ist. Darüber hinaus können Orchestrierungs-Tools wie LangChain oder LlamaIndex erforderlich sein, um die verschiedenen Komponenten effizient zu koordinieren und den Workflow zu optimieren.

Kosten für API-Aufrufe

Jede Suchanfrage verursacht mehrere API-Aufrufe: einmal für das Embedding der Frage, einmal für die Suche in der Datenbank, und einmal für die Generierung der Antwort. Bei hohem Volumen können diese Kosten relevant werden.

Relevanz-Probleme

Manchmal findet das System zwar semantisch ähnliche Dokumente, die aber nicht den Kern deiner Frage treffen. Die Herausforderung liegt darin, das Retrieval so zu kalibrieren, dass es wirklich die hilfreichsten Dokumente findet.

Chunk-Size und -Überlappung

Wie teilst du lange Dokumente am besten auf? Zu kleine Chunks verlieren den Kontext, zu große Chunks werden unspezifisch. Das erfordert Experimentieren und Feinabstimmung.

Multimodale Inhalte

Während Text-Embeddings ausgereift sind, ist die Integration von Bildern, Tabellen, Diagrammen oder Videos noch herausfordernder. Wenn wichtige Informationen in diesen Formaten vorliegen, musst du besondere Strategien entwickeln.

Latenz und Performance

Bei sehr großen Wissensdatenbanken kann die Suche länger dauern. Du musst einen Kompromiss zwischen Gründlichkeit und Geschwindigkeit finden.

Best Practices für die Implementierung

Um die Vorteile zu maximieren und die Herausforderungen zu minimieren, hier einige bewährte Ansätze:

Kläre Use Case und Requirements vorab: Definiere vor der Implementierung, welche Fragen das System beantworten soll und welche Antwortqualität erwartet wird. Analysiere Input (Dokumenttypen, Quellen, Formate) und Output (Antwortlänge, Detailgrad, Quellenangaben). Diese Vorarbeit verhindert, dass du ein technisch funktionierendes System baust, das an den tatsächlichen Nutzeranforderungen vorbeigeht.

Starte klein und skaliere: Beginne mit einem klar definierten Anwendungsfall und einer überschaubaren Wissensdatenbank. Sammle Erfahrungen, bevor du das System ausbaust.

Investiere in die Datenqualität: Nimm dir Zeit, deine Dokumente zu bereinigen, zu strukturieren und mit Metadaten anzureichern. Das zahlt sich langfristig vielfach aus.

Implementiere Feedback-Schleifen: Lass Nutzer bewerten, ob Antworten hilfreich waren. Diese Rückmeldungen helfen dir, das System kontinuierlich zu verbessern.

Fazit

RAG und Embeddings sind die unsichtbaren Helfer, die moderne KI-Systeme so leistungsfähig machen. Sie ermöglichen es, dass KI nicht nur auf ihr Trainingswissen angewiesen ist, sondern aktiv auf aktuelle und spezifische Informationen zugreifen kann. Für Unternehmen bedeutet das die Möglichkeit, KI-Systeme zu entwickeln, die wirklich auf ihre spezifischen Bedürfnisse zugeschnitten sind – sei es für Kundenservice, interne Wissensdatenbanken oder spezialisierte Anwendungen.

Die Technologie ist bereits weit fortgeschritten und etabliert und wird von führenden Unternehmen weltweit eingesetzt. Mit dem richtigen Verständnis dieser Konzepte und einer durchdachten Implementierung kannst auch du die Vorteile dieser revolutionären Technologien nutzen.